[머신러닝] K-Nearest Neighbors

혼공머신으로 공부하고 정리하는 공부목적 페이지 입니다.

K-Nearest Neighbors

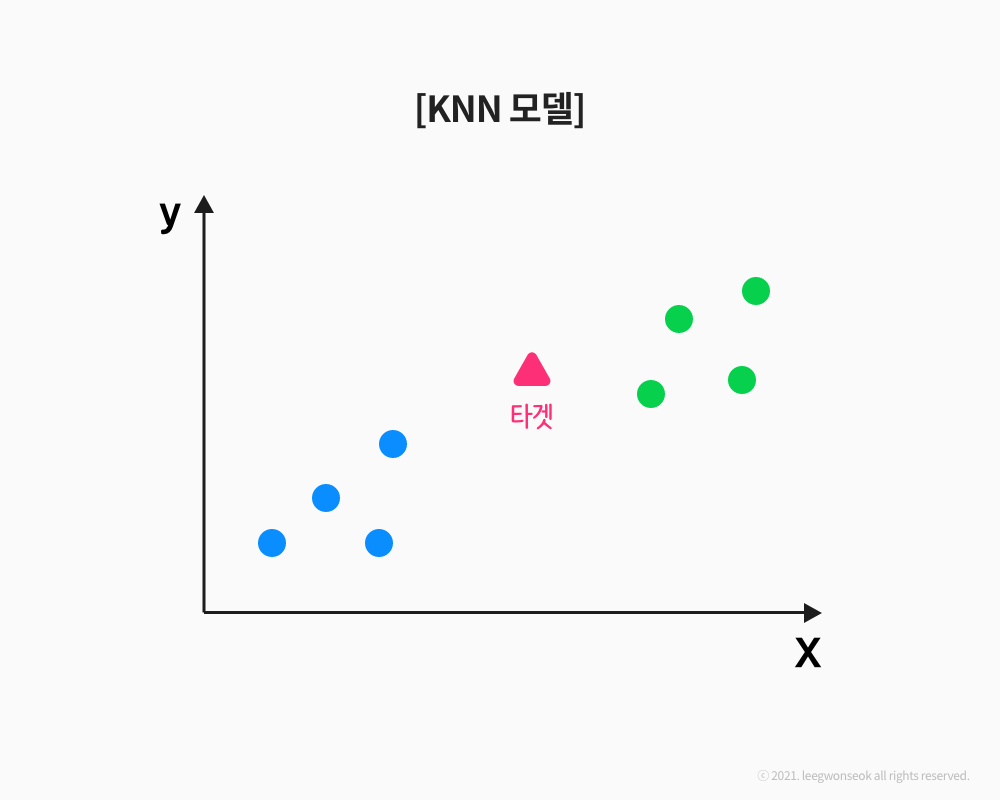

정의

K-최근접 이웃 모델은 새로운 데이터를 입력 받았을 때 가장 가까이 있는 것이 무엇이냐를 중심으로 새로운 데이터의 종류를 정해주는 알고리즘. 비슷비슷한 값들끼리 있을 때 사용하기 좋다

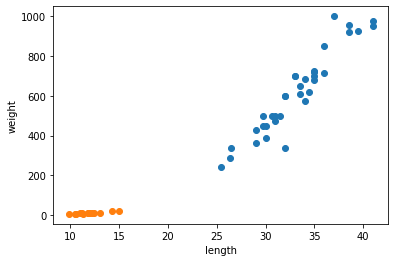

예시] KNN모델로 생선 분류하기

## bream data

bream_length = [25.4, 26.3, 26.5, 29.0, 29.0, 29.7, 29.7, 30.0, 30.0, 30.7, 31.0, 31.0, 31.5, 32.0, 32.0,

32.0, 33.0, 33.0, 33.5, 33.5, 34.0, 34.0, 34.5, 35.0, 35.0, 35.0, 35.0, 36.0, 36.0, 37.0,

38.5, 38.5, 39.5, 41.0, 41.0]

bream_weight = [242.0, 290.0, 340.0, 363.0, 430.0, 450.0, 500.0, 390.0, 450.0, 500.0, 475.0, 500.0, 500.0,

340.0, 600.0, 600.0, 700.0, 700.0, 610.0, 650.0, 575.0, 685.0, 620.0, 680.0, 700.0, 725.0,

720.0, 714.0, 850.0, 1000.0, 920.0, 955.0, 925.0, 975.0, 950.0]

## smelt data

smelt_length = [9.8, 10.5, 10.6, 11.0, 11.2, 11.3, 11.8, 11.8, 12.0, 12.2, 12.4, 13.0, 14.3, 15.0]

smelt_weight = [6.7, 7.5, 7.0, 9.7, 9.8, 8.7, 10.0, 9.9, 9.8, 12.2, 13.4, 12.2, 19.7, 19.9]

import matplotlib.pyplot as plt

plt.scatter(bream_length, bream_weight)

plt.scatter(smelt_length, smelt_weight)

plt.xlabel('length')

plt.ylabel('weight')

plt.show()

# scatter 함수를 바로 밑에 똑같이 넣어주면 그래프가 다음과 같이 나온다.

[Output]

length = bream_length + smelt_length # 두 리스트를 합친다

weight = bream_weight + smelt_weight

fish_data = [[l,w] for l, w in zip(length, weight)] # zip(A, B) : A리스트와 B리스트에서 하나씩 뽑음

print(fish_data)

[[25.4, 242.0], [26.3, 290.0], [26.5, 340.0], [29.0, 363.0], [29.0, 430.0], [29.7, 450.0], [29.7, 500.0], [30.0, 390.0], [30.0, 450.0], [30.7, 500.0], [31.0, 475.0], [31.0, 500.0], [31.5, 500.0], [32.0, 340.0], [32.0, 600.0], [32.0, 600.0], [33.0, 700.0], [33.0, 700.0], [33.5, 610.0], [33.5, 650.0], [34.0, 575.0], [34.0, 685.0], [34.5, 620.0], [35.0, 680.0], [35.0, 700.0], [35.0, 725.0], [35.0, 720.0], [36.0, 714.0], [36.0, 850.0], [37.0, 1000.0], [38.5, 920.0], [38.5, 955.0], [39.5, 925.0], [41.0, 975.0], [41.0, 950.0], [9.8, 6.7], [10.5, 7.5], [10.6, 7.0], [11.0, 9.7], [11.2, 9.8], [11.3, 8.7], [11.8, 10.0], [11.8, 9.9], [12.0, 9.8], [12.2, 12.2], [12.4, 13.4], [13.0, 12.2], [14.3, 19.7], [15.0, 19.9]]

fish_target = [1]*35 + [0]*14 # bream = 1, smelt = 0 으로 표현

# 보통 찾고자 하는 것을 1로 그 외를 0으로 잡는 경향이 있음

print(fish_target)

[1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0]

from sklearn.neighbors import KNeighborsClassifier # 해당 K 이웃모델 모듈 호출

kn = KNeighborsClassifier() # K 이웃모델 객체 생성

kn.fit(fish_data, fish_target) # 'fish_data'의 값들을 이진으로 표현한 'fish_target'에 대입시키기

# fit(input, target) : 모델을 훈련시키는 함수

KNeighborsClassifier(algorithm='auto', leaf_size=30, metric='minkowski',

metric_params=None, n_jobs=None, n_neighbors=5, p=2,

weights='uniform')

kn.score(fish_data, fish_target)

# score(input, target) : 모델의 점수를 확인하는 함수, 0~1 사이의 값이 온다

1.0

kn.predict([[30, 600]]) # [[]] 으로 표현한 이유? : length 값과 weight 값을 리스트in리스트로 표현해서

# predict() : 새로운 데이터가 들어왔을때 해당 모델을 돌려 예측하게 하는 함수

array([1])

## 이해하기

print(kn._fit_X)

print()

print(kn._y)

kn49 = KNeighborsClassifier(n_neighbors=49) # 파라미터 'n_neighbors=n' :

결론]

만약에 크게 값이 벗어나지 않는 값을 예측하는 것이면 KNN 모델을 사용해도 괜찮은거 같다.